рефераты конспекты курсовые дипломные лекции шпоры

- Раздел Полиграфия

- /

- Количество информации, получаемой в сообщении

Реферат Курсовая Конспект

Количество информации, получаемой в сообщении

Количество информации, получаемой в сообщении - раздел Полиграфия, Информации. Кодирование символьных, графических и звуковых данных. Структуры данных До Сих Пор Формулы Приводились Для Расчета Энтропии (Неопределенности) H С Ук...

До сих пор формулы приводились для расчета энтропии (неопределенности) H с указанием на то, что H в них можно заменять на I, потому что количество информации, получаемое при полном снятии неопределенностинекоторой ситуации, количественно равно начальной энтропии этой ситуации.

Но в общем случае неопределенность может быть снята только частично, поэтому количество информации (I), получаемой из некоторого сообщения, вычисляется как уменьшение энтропии, произошедшее в результате получения данного сообщения.

Для равновероятного случая, используя для расчета информации формулу Хартли, получим:

Как видно, второе равенство выводится на основании свойств логарифма. Таким образом, в равновероятном случае I зависит от того, во сколько раз изменилось количество вариантов выбора (рассматриваемое разнообразие).

Исходя из предыдущей формулы, можно сделать вывод, что при полном снятии неопределенности, когда Nпосле = 1:

количество полученной в сообщении информации равно неопределенности, которая существовала до получения сообщения.

Если же Nпосле = Nдо, то I = log2(1) = 0, то это значит, что, неопределенность не изменилась, и, следовательно, информации получено не было.

Если Nпосле < Nдо, то Nдо / Nпосле > 1, или I > 0 (какая-то информация получена).

Если Nпосле > Nдо, то Nдо / Nпосле < 1, или I < 0 (информации нет).

Таким образом, количество полученной информации будет положительной величиной, если в результате получения сообщения количество рассматриваемых альтернатив уменьшилось, и отрицательной, - если оно увеличилось.

Если, например, количество рассматриваемых вариантов в результате получения сообщения уменьшилось вдвое, т. е. Nдо / Nпосле = 2, то I = log2(2) = 1 бит. Другими словами, получение 1 бита информации исключает из рассмотрения половинуравнозначныхвариантов.

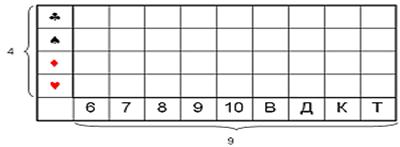

В качестве примера можно рассмотреть опыт с колодой из 36карт.

Допустим, кто-то выбирает одну карту из колоды. Нас интересует, какую именно из 36 карт он достал. Начальная неопределенность, рассчитываемая по формуле I = log2(Nдо / Nпосле), составляет:

I = log2(36/1) = log10(36) * 3,332 @ 5,17 бит.

Вытянувший карту сообщает нам часть информации. Используя формулу, определим, какое количество информации мы получаем из этих сообщений:

Вариант A. “Это карта красной масти”.

I = log2(36/18) = log2(2) = 1 бит (красных карт в колоде половина, поэтому неопределенность уменьшилась в 2 раза).

Вариант B. “Это карта пиковой масти”.

I = log2(36/9) = log2(4) = 2 бита (пиковые карты составляют четверть колоды, неопределенность уменьшилась в 4 раза).

Вариант С. “Это одна из старших карт: валет, дама, король или туз”.

I = log2(36/16) = log2(36) – log2(16) = 5,17 – 4 = 1,17 бита (количество информации больше одного бита, т. к. неопределенность уменьшилась больше, чем в два раза).

Вариант D. “Это одна карта из колоды".

I = log2(36/36) = log2(1) = 0 бит (неопределенность не уменьшилась - сообщение не информативно).

Вариант E. “Это дама пик". I=log2(36/1)=log2(36)=5,17 бит (неопределенность полностью снята).

– Конец работы –

Эта тема принадлежит разделу:

Информации. Кодирование символьных, графических и звуковых данных. Структуры данных

Информации Кодирование символьных графических и звуковых данных Структуры данных Формула... Log log... Основные свойства логарифмов...

Если Вам нужно дополнительный материал на эту тему, или Вы не нашли то, что искали, рекомендуем воспользоваться поиском по нашей базе работ: Количество информации, получаемой в сообщении

Что будем делать с полученным материалом:

Если этот материал оказался полезным ля Вас, Вы можете сохранить его на свою страничку в социальных сетях:

| Твитнуть |

Хотите получать на электронную почту самые свежие новости?

Новости и инфо для студентов